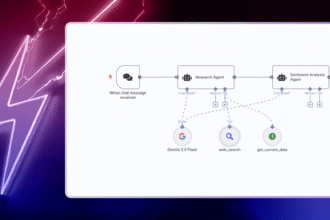

Künstliche Intelligenz verändert, wie wir arbeiten – von Produktivitätstools bis zu Chatbots. Doch KI bringt auch Unberechenbarkeit mit sich. Kleine Änderungen am Prompt oder ein anderes LLM-Modell führen oft zu völlig anderen Ergebnissen. Genau hier setzt eine neue Funktion in n8n an: AI Evaluations. Jetzt können Entwickler und Automatisierer ihre KI-Prozesse direkt in n8n testen, analysieren und verbessern – einfacher und transparenter als je zuvor.

Was sind AI Evaluations in n8n?

Evaluations sind spezielle Pfade innerhalb eines Workflows, die gezielt Tests von KI-Aktionen ermöglichen. Sie können eine Vielzahl an Eingaben automatisiert durch Ihren Workflow schicken, die Ausgaben beobachten und eigene Qualitätsmetriken anlegen und bewerten.

Ob Korrektheit, Bias, Ausführungszeit oder die Frage, ob der richtige Agent aktiviert wurde – AI Evaluations machen Ihre Tests messbar und vergleichbar. So lässt sich über die Zeit hinweg fundiert beurteilen, ob Updates (wie Prompt-Änderungen oder neue Modelle) zu besseren Ergebnissen führen oder nicht.

Vorteile der neuen Evaluations-Funktion

- Getrennte Testpfade ohne Einfluss auf produktive Workflows

- Eigene Metriken definierbar (Textanalyse oder technische Werte)

- Schnelleres Troubleshooting durch visuelles Debugging

- Volle Integration innerhalb der n8n-Plattform – kein Toolwechsel nötig

Wieso sind Evaluations für KI so wichtig?

Es gibt viele Gründe, warum diese Funktion einen echten Meilenstein für KI-Workflows darstellt. Besonders hilfreich ist sie in folgenden Bereichen:

1. Sicherer deployen – auch in die Produktion

Prompt-Engineering ist komplex. Eine kleine Änderung kann ungeahnte Effekte haben – sowohl gute als auch schlechte. Mit AI Evaluations können Sie Ihre Änderungen gezielt testen, ohne reale Nutzer zu beeinflussen. Das gibt Ihnen Sicherheit, ob eine Anpassung tatsächlich einen Fortschritt bringt.

2. Schneller experimentieren und iterieren

KI-Prozesse bestehen aus vielen beweglichen Teilen: von der Datenstruktur über den Prompt bis hin zu Tools und Modellen. AI Evaluations erlauben es, einzelne Elemente gezielt zu verändern und direkt zu beobachten, was sich wie auswirkt.

3. Verschiedene LLMs gegeneinander testen

Der Markt für Sprachmodelle boomt. Doch welches Modell überzeugt wirklich? Mit der Evaluations-Funktion lassen sich Modelle wie GPT-4, Claude oder Mixtral direkt gegeneinander testen – basierend auf Ihren echten Use Cases.

4. Qualitätsstandards sicherstellen

Zuverlässigkeit ist das A und O bei Automationen. KI-Workflows liefern oft kritische Daten. Deshalb ist es entscheidend, Qualität und Korrektheit regelmäßig zu prüfen. AI Evaluations machen das zum Standard – ohne zusätzliche Tools, direkt in Ihrem bestehenden Setup.

Best Practices: So holen Sie das Maximum aus Evaluations heraus

Vergleichsfragen statt Notensystem

Das Team von n8n hat bei eigenen Tests festgestellt, dass Vergleichsfragen („Ist die neue Antwort besser als die alte?“) weit bessere Ergebnisse liefern als klassische Skalenbewertungen. Das reduziere subjektive Abweichungen und führe zu konsistenterem Feedback.

Quantifizierbare Metriken nutzen

- Anzahl der Tokens

- Wie oft Tools aufgerufen wurden

- Ob bestimmte Tools korrekt angesprungen wurden

Diese Metriken liefern harte Zahlen, die qualitative Bewertungsfragen ergänzen – ideal für tiefere Analysen.

Reale Daten für besseres Testing

Tests auf Basis historischer Echt-Daten aus Ihrer Automatisierung decken nicht nur Standardfälle ab, sondern auch Edge Cases, merkwürdige Formate oder untypische Nutzereingaben. Das erhöht die Aussagekraft Ihrer Evaluation signifikant.

Wie n8n die Evaluations-Funktion entwickelt hat

Die Funktion wurde direkt auf dem bekannten n8n-Ausführungsmodul gebaut. So erleben Nutzer konsistentes Verhalten – egal ob im Live-Betrieb oder beim Testen. Dank dieser Architektur laufen Verbesserungen am Execution Engine automatisch auch für Evaluations mit.

Der wohl größte Spagat? Die Komplexität von Tests, Metrikdefinition und Analyse so zu balancieren, dass auch Einsteiger*innen den Einstieg finden. Hier half intensives Beta-Testing mit der Community, das Interface mehrmals zu überarbeiten – zugunsten von Einfachheit bei vollem Funktionsumfang.

Wichtige Learnings

- Früh testen zahlt sich aus: Feedback der Community half, die UX massiv zu verbessern.

- Einfachheit gewinnt: KI muss nicht kompliziert sein – auch Evaluationen sollten intuitiv nutzbar sein.

- n8n ist flexibler als gedacht: Die Meta-Fähigkeit, Workflows durch Workflows zu testen, eröffnet neue Möglichkeiten.

Sie möchten mehr erfahren? Dann werfen Sie einen Blick in die offizielle Dokumentation oder besuchen Sie das Event am 2. Juli 2025 (17:00 – 18:00 Uhr) zum Thema „From Prompt to Production“ mit KI-Experte Elvis Saravia, Ph.D..

Fazit: Evaluationen bringen Struktur ins KI-Chaos

Künstliche Intelligenz entfaltet ihr Potenzial nur dann voll, wenn sie kontrollierbar und nachvollziehbar ist. AI Evaluations in n8n bieten genau das: eine elegante, integrierte Lösung, um Ihre Systeme dauerhaft zu verbessern. Automatisieren, Testen, Vertrauen – alles auf einer Plattform.

Mehr zum Thema Tech Trends und Make.com Automation finden Sie in unserem Blog.